Ha riscosso grande interesse l’incontro “A colloquio con ChatGPT” organizzato da Fondazione Pesenti e Fondazione Corriere della Sera e trasmesso in diretta streaming sul sito Corriere.it.

Introdotto da Carlo Pesenti, Presidente della Fondazione Pesenti, e moderato dal giornalista Massimo Sideri, il convegno ha visto il coinvolgimento di alcuni ospiti illustri che hanno spiegato funzionamento, potenzialità e rischi del Chat Generative Pre-trained Transformer (da cui l’acronimo ChatGPT) sviluppato da OpenAI e specializzato nella conversazione con un utente umano.

|

|

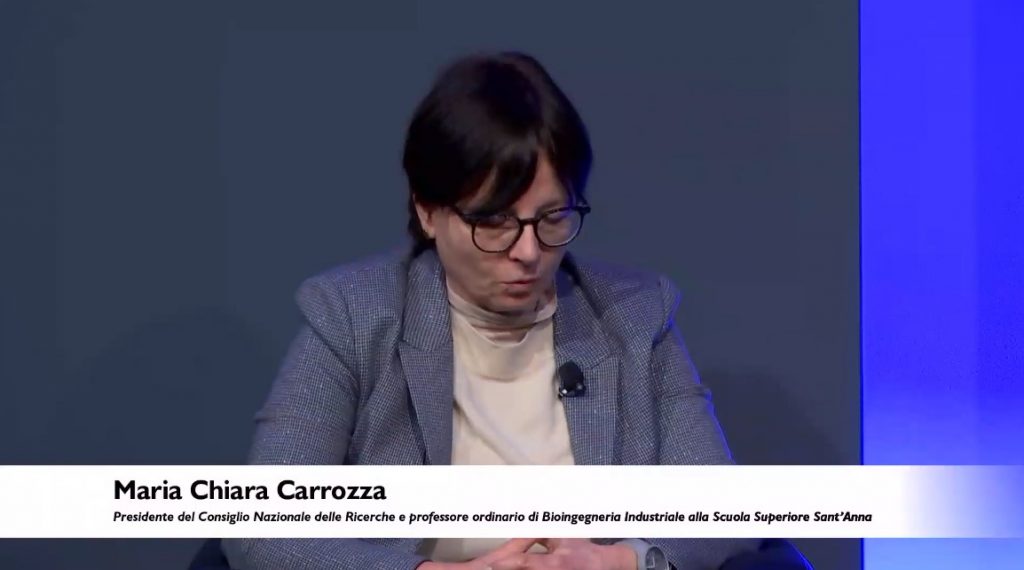

La prima a prendere la parola è stata Maria Chiara Carrozza, presidente del Consiglio Nazionale delle Ricerche e professore ordinario di Bioingegneria Industriale alla Scuola Superiore Sant’Anna “È importante chiedersi a cosa serve l’intelligenza artificiale. Dobbiamo chiederci se questi strumenti serviranno a far progredire l’umanità, se l’intelligenza artificiale avrà un impatto sulla vita di tutti noi e quali possono essere le estreme conseguenze dell’automazione dell’attività cognitiva, che è molto diversa dall’automazione dell’attività fisica che i robot hanno portato nelle fabbriche. L’automazione nelle fabbriche ha permesso di eliminare lavori ripetitivi e logoranti, l’intelligenza artificiale cognitiva va invece a incidere su ciò che di più umano abbiamo, la creatività”.

Luciano Floridi, professore ordinario di Filosofia ed Etica dell’informazione all’Università di Oxford ha sottolineato l’importanza di comprendere il funzionamento di questi sistemi, anche nell’ottica di sfruttare al meglio le loro potenzialità “Interrogando ChatGPT se ne colgono i limiti, ma sono limiti interessanti. Il sistema produce contenuti attraverso elementi puramente sintattici e probabilistici dall’analisi di enormi quantità di dati. Non ha comprensione, intelligenza né competenza semantica, ma il risultato è comunque straordinario. In un mondo, quello di oggi, che va molto più veloce che in passato, le IA potrebbero ad esempio fungere da interfaccia tra noi e la conoscenza, il sapere che si accumula. Così facendo bisogna però tener presente la distanza che si crea tra noi e questo sapere, che a lungo andare può divenire elemento di criticità. In conclusione, le IA attuali sono solo strumenti, la responsabilità del loro utilizzo è nostra ed è un’enorme responsabilità, perché chi controlla le domande controlla le risposte, e chi controlla le risposte controlla la realtà”.

|

|

Roberto Battiston, professore ordinario di Fisica Sperimentale dell’Università di Trento, già Presidente dell’Agenzia Spaziale Italiana, ha aggiunto “ChatGPT crea la straordinaria illusione di dialogare con un essere umano, è un’illusione irresistibile pensare che sia simile a noi. Dobbiamo invece capire che abbiamo solo a che fare con una macchina, e sforzarci di comprenderla. Dobbiamo ad esempio sapere che il sistema non copia, ma genera nuovi testi. Applicando un algoritmo meramente probabilistico combina l’insieme delle informazioni su internet, ovvero la nostra intelligenza collettiva, per creare qualcosa di nuovo. È un modo di indicizzare efficacemente un insieme di frasi che abbiamo scritto e farne qualcosa che a livello linguistico è splendido, ma non lo è sotto il profilo della correttezza, le informazioni che ci dà possono infatti essere anche totalmente sbagliate, in quanto frutto solo di una combinazione probabilistica. Basta fare domande mirate per rendersene conto. Altra cosa da sapere è che il risultato di Chat GPT è frutto di filtri, le prime versioni ne avevano di deboli, per questo sorgevamo problemi etici. È stato quindi affinato, programmato per restituire risultati accettabili. Ma chi giudica l’appropriatezza di questi risultati? Chi programma il sistema? Con quali finalità? Ecco che sorgono altri dilemmi etici. Al momento ciò che dà il ritmo dell’etica è l’economia, perché ciò che non è appropriato non vende. Ma in futuro chissà cosa potrebbe accadere”.

Ferruccio de Bortoli, Presidente Fondazione Corriere della Sera, ha concluso “È lecito avere dei dubbi, ma questo non deve impedirci di esplorare le potenzialità di questi sistemi, perché se ce ne teniamo solo a distanza richiamo di subirne solo l’influenza, senza capirne il funzionamento. Per questo credo sia determinante capire come funziona il meccanismo, avere trasparenza, comprendere come è gestito. Chi modera? Con quali libertà? Con quali facoltà? Queste sono a mio avviso alcune elle più importanti domande che dobbiamo porci. Altro tema legato a sistemi come ChatGPT è la distanza che creano tra fonte e informazione. Google sino ad ora ci ha fornito una serie di risultati con relative fonti, ChatGPT rivoluziona totalmente questo paradigma. Qual è il momento in cui questa ricerca finisce per essere manipolazione, distorsione?”

|

|